Ollama 是一个开源的大模型服务工具,可以支持 Llama 3,Phi 3,Mistral,Gemma 和其他多种模型,也可以创建自己的模型,并且支持 MacOS,Linux,以及 Windows 多种系统。

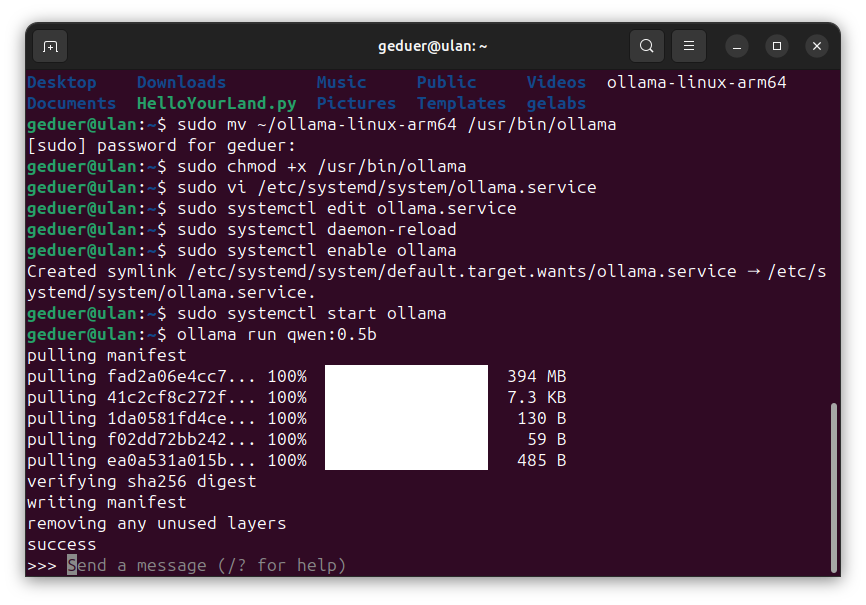

1.下载 Ollama 可执行文件

打开幽兰命令行终端,输入以下命令:

wget https://ollama.com/download/ollama-linux-arm64下载可能需要特殊的网络环境。下载结束后,我们将 Ollama 放到 /usr/bin 目录下,为了方便将名字改成 Ollama,然后添加可执行权限:

sudo mv ~/ollama-linux-arm64 /usr/bin/ollama

sudo chmod +x /usr/bin/ollama2.配置 Ollama

在 /etc/systemd/system/ 下创建服务文件 ollama.service:

sudo vi /etc/systemd/system/ollama.service在 vi 界面,输入 i 进入输入模式,然后添加下面内容:

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

[Install]

WantedBy=default.target然后按 ESC 键位,输入 :wq保存即可。

接下来配置 Ollama,自定义模型存放路径:

sudo systemctl edit ollama.service同样用上面的方法,将下面的内容输入进去。在这里/gewu/这个文件夹就是我指定的模型存放路径,大家可以根据自己需求进行更改,比如/home/geduer也可以。

[Service]

Environment="OLLAMA_MODELS=/gewu/"3.启动 Ollama 服务

在输入下面命令即可启动:

sudo systemctl daemon-reload

sudo systemctl enable ollama

sudo systemctl start ollama这三条命令只需要输入一次,即使关机下次重新开机,也不需要再输入了。

4.使用 Ollama

考虑到笔记本性能有限,在这里我们运行的大语言模型为阿里云开发的 Qwen 0.5b,在命令行输入下面命令即可:

ollama run qwen:0.5b由于初次启动 Qwen 模型,需要从 Ollama 网站下载模型文件,所以时间较长。如果下载出错,可以多试几次,等待加载完毕,出现下面的提示信息时,就可以体验了。

下次再使用时,不必再下载模型文件,会直接进入。

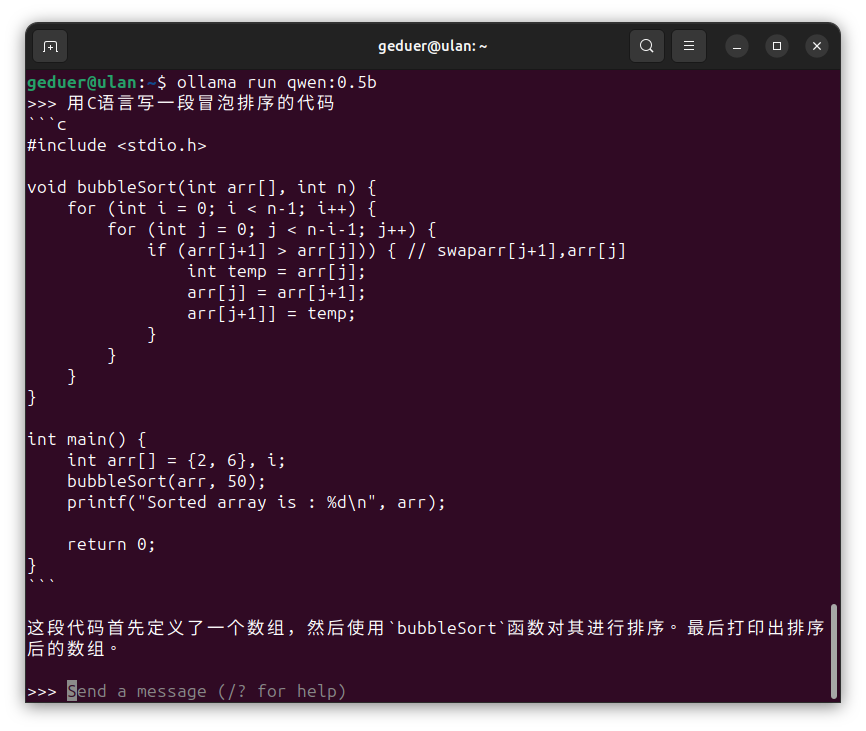

现在你可以输入任何问题了。

当你问完问题想退出时,输入:

>>> /bye即可。

作者:李宜桐 创建时间:2024-05-09 13:57

最后编辑:沈根成 更新时间:2026-01-12 19:29

最后编辑:沈根成 更新时间:2026-01-12 19:29